译者前言

这是来自@desunit博客中的一篇文章,这篇文章主要介绍了“长期依赖LLM(语言大模型)的代价”。

我个人觉得这篇文章还蛮有想法和深刻见解的,也从一定程度上缓解了我对AI工具大行其道的焦虑感,帮助我更好地正确看待和使用AI产品。故将其英文内容翻译成中文,分享收录到我的博客之中。

正文翻译

当我们把认知负担交由语言大模型时所感到的轻松舒适是有坏处的。认知负担应该存在,如果我们削减太多的认知负担——如果我们停止思考——我们就可能不知道如何思考了。

那些一直走捷径抄作业的孩子最终会发现他们完全对学校教了什么一无所知。一直让他们伴侣操持账单和银行业务的人终究一天可能不再能够独自管理了,甚至只是一个简单的支出项。一个从不费心去了解街道名称和路线的人,点那个他们的手机死机的时候就会迷路,甚至不知道如何回家。

这就又要回到Nassim Taleb在他有深刻见解的《反脆弱》一书中所说的hromesis1概念了,少量的压力和不适使我们变得更强。

- 肌肉通过举重增长

- 暴露接触形成免疫

- 通过冒险增长信心

- 不断重复增进技能

- 通过解决难题拓展创造力

大脑也是这样工作的。思考时的阻力,去寻找正确词语时的努力——那就是心灵上的举重。

或许这还有一个稍微不同但又神似的例子——破窗理论。该理论说那些可见的混乱迹象——像是涂鸦、垃圾和破窗——表明对混乱的的忽视是可以容忍的,降低了非正式的管控的同时又使得不好的行为更多了,甚至成为了严重的犯罪行为。换句话说,当一些小裂痕没有被解决,它们会级联起来成为一个更大的裂缝。对大模型的持续依赖会让问题越来越严重,直到我们外包出去我们所有的思考活动,变成了只不过是具有生物特征的木偶。

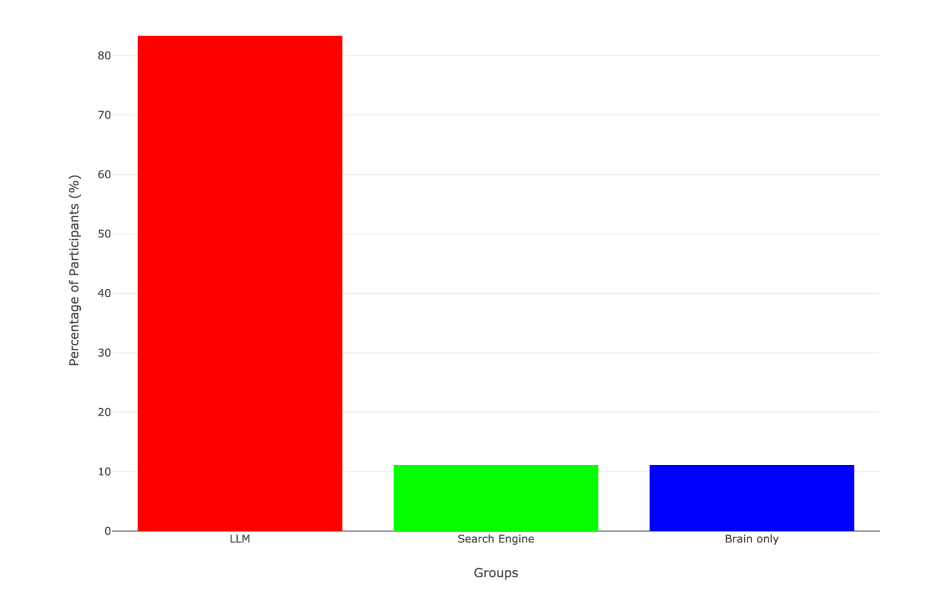

最近甚至有研究来支持这个观点。在一项研究中,参与者被分为三组:

- 只用大脑:没有其他帮助地写作

- 搜索引擎:使用Google搜索

- 大模型(ChatGPT):完全依赖ChatGPT

结果如下:

- 在大模型的组中,83%的人都不能在他们完成写作后从他们自己的文章简短地引述任何内容,然而几乎所有在其他组的人都可以做到。

- 从使用LLM转向独立写作的参与者表现出神经系统活跃度下降和持续的、不高的投入度。

- 从只用大脑转变到大模型的参与者具有很强的回忆并和搜索引擎组展示出相似的神经活跃模式。

他们发明了一个新词“认知债务”来描述这种取舍:AI助手快捷的代价可能是长期的认知思维能力的牺牲,像是批判性思维,记忆保持和独立的创造性。你借用了机器的认知能力却也为了付出了代价,这个代价会在之后展现出来,当你自己的思考能力已经变弱时。

我一直跟我的孩子们说,大模型确实是一个强有力的工具,但一定要聪明地使用它。不要询问它去解决你的数学方程式;而是提供你自己的答案并且让它说明你可能错在哪里。以独立思考为始,继而装备上AI就会使人知发展变得更健康。这就像是核能力一样,你可以用它进行大规模破坏也可以作为一种清洁能源。

持续地依赖AI工具会削弱学习能力,记忆力和创造力。不适感不仅仅是一个讨厌的事情——它还是一个训练场。

寻找这种不适感,找出它并且以此激励自己。

注解

- hromesis 在生物学和毒理学中,指低剂量应激或毒素对生物体产生的有益效应。在这里译者没有找到很好的中文翻译。

为了贴合中文读者的语言习惯,全文基本上都是古法翻译的,如有错误之处烦请指出、不吝赐教。

本文翻译尚未获取授权,如有侵权,请联系我删除本次翻译已获得原文作者授权